Russian

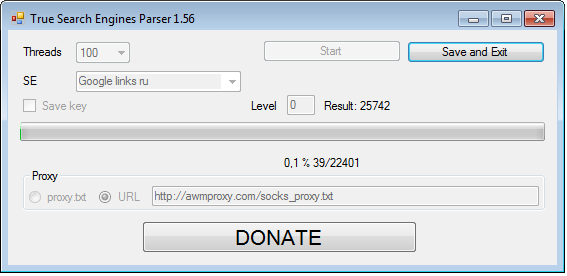

True Search Engines Parser предназначен для парсинга ссылок, сниппетов, подсказок поисковых систем Google, Yandex. Первая версия данного парсера вышла в 2012 году и использовался он в узком кругу, 26.06.2016 выложен здесь для всех.

Системные требования

Windows XP, 7, 8, 8.1, 10

Описание параметров

Threads – количество потоков.

SE – выбор поисковой системы и языка.

Save key – Сохранять ли ключ по которому найден результат. В data.txt результат будет http://example.com/[PARAM]: Авто

Level – глубина парсинга. Количество страниц, которое нужно открыть (для Google на каждой странице 100 результатов, и максимум 10 страниц). 0 – парсить до самого конца (для Google 10)

Proxy – брать из файла proxy.txt или подгружать прокси по указанному адресу каждую минуту. Важно!!! Программа без прокси не работает, так как ПС быстро блокируют ip и выдают капчу.

Файл keys.txt – запросы

Файл proxy.txt – прокси-серверы (заполнять если выбрано брать прокси из файла, а не подгружать по URL)

Файлы нужно заполнять перед запуском проги, и обязательно в кодировке utf-8.

Сравнение скорости и цены различных платных сервисов прокси-серверов

Скорость замеряется на первых 5 минутах работы парсера ссылок на 300 потоках, запросы не содержат операторов вроде inurl.

Конкретный пример использования парсера

Допустим стоит задача спарсить сайты на движке Joomla. Признак этого движка – наличие «option=com_content» в URL. Если вбить в Google запрос inurl:»option=com_content» то Google выдаст не более 1 000 результатов, для того чтобы спарсить больше сайтов нужно использовать вариаторы. Это выглядит примерно так:

inurl:»option=com_content» Авто

inurl:»option=com_content» Ремонт

Чтобы автоматически создать большой список нужных вариаторов можно использовать программу Комбинаторика. Программа делает вариации из 2-х списков. К примеру если на входе есть:

1 список:

key1

key2

2 список:

key3

key4

То на выходе получается:

key1 key3

key1 key4

key2 key3

key2 key4

В комплекте есть несколько словарей-вариаторов. Возьмём два любых списка вариаторов, к примеру «вариаторы towns bez stran.txt» и «вариаторы высокочастотные.txt». Кладём эти списки в «1.txt» и «2.txt» соответственно, запускаем прогу, в разделитель вводим пробел вместо двоеточий, нажимаем комбинаторика, закрываем прогу — в data.txt получили 7,5 млн запросов))) осталось добавить признак движка: переименовываем data.txt в 2.txt, а в 1.txt вводим признак к примеру inurl:»option=com_content». Запускаем, разделитель снова пробел, и на выходе получаем что-то типа:

inurl:»option=com_content» Абаза год

inurl:»option=com_content» Абаза человек

inurl:»option=com_content» Абаза время

inurl:»option=com_content» Абаза дело

То что и требовалось. Теперь подсовываем этот список в True Search Engines Parser

True Search Engines Parser is designed for parsing links, snippets and search prompts in Google search engine. The first edition of this parser was released in 2012 for a narrow circle of users, and since 26.06.2016 it has been available for everyone on this website.

System Requirements

Windows XP, 7, 8, 8.1, 10

Parameters

Threads – the number of threads.

SE – the choice of a search engine and a language.

Save key – choose whether to save the key, which is used to search for results. In data.txt the results will be saved according to the formula: http://example.com/[PARAM]: Авто

Level – the parsing depth. The number of pages that will be opened (as for Google, it has 100 results on each page with the maximum of 10 pages). Set the parameter to 0 to search through the maximum number of pages (10 for Google).

Proxy – choose whether to take them from the proxy.txt file or from a given link once a minute. Attention!!! The program doesn’t work without proxy, because the search engines quickly block the ip and start giving out captchas.

keys.txt – the file with keys.

proxy.txt – the file with proxy-servers (you need to fill the file it the Proxy parameter is set to take proxy from the file and not from a URL)

The files need to be filled before starting the program, and only in utf-8.

Comparison of various proxy services in speed and price

The speed was measured in the first five minutes of the link parser’s work at 300 threads, the keys didn’t contain any additional parameters like inurl.

A case of using the parser

Let’s assume that we need to parse all the websites built on Joomla engine. A characteristic feature of Joomla is having «option=com_content» in URLs. So if you use inurl:»option=com_content» in the search query, Google will give out no more than 1 000 results. To parse more websites we are going to need more variations of queries. It can look like this:

inurl:»option=com_content» automobile

inurl:»option=com_content» car repair

To create a large list of keys you can use a special program that makes combinations of keys from two lists — Combinations. For example, initially we have:

List 1:

key1

key2

List 2:

key3

key4

Then we get:

key1 key3

key1 key4

key2 key3

key2 key4

Together with the program you get some lists of thematic keys, which you can use to make combinations (only lists in Russian are available now). Let’s take any two of the lists, for example «towns no countries.txt» and «high frequency queries.txt». Put these lists into «1.txt» and «2.txt» respectively, run the program, set a space as a divider instead of a colon, press Combinations, close the program. Now you have 7.5 million keys in data.txt, and you only have to add a feature of an engine to them for example, inurl:»option=com_content». So we run the program again, and use a spase as the divider again. As a result we get a list of queries which look like the following:

inurl:»option=com_content» Allentown year

inurl:»option=com_content» Allentown people

inurl:»option=com_content» Allentown time

inurl:»option=com_content» Allentown affairs

That’s just what we need. Now just add this list into True Search Engines Parser

Добрый день! Парсер из этой статьи не обновляли? Тестировал его в работе, не парсит и не сохраняет ссылки.

Здравствуйте.

Видимо верстка на сайте google поменялась.

Возможно в будущем исправлю это